目錄

- 前言

- 前文

- 一���、明確需求

- 三���、解析數據

- 四、保存數據(數據持久化)

前言

本文的文字及圖片來源于網絡,僅供學習��、交流使用,不具有任何商業(yè)用途,如有問題請及時聯(lián)系我們以作處理��。

前文

01����、python爬蟲入門教程01:豆瓣Top電影爬取

基本開發(fā)環(huán)境

相關模塊的使用

安裝Python并添加到環(huán)境變量,pip安裝需要的相關模塊即可�����。

單章爬取

一����、明確需求

爬取小說內容保存到本地

# 第一章小說url地址

url = 'http://www.biquges.com/52_52642/25585323.html'

url = 'http://www.biquges.com/52_52642/25585323.html'

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=url, headers=headers)

print(response.text)

請求網頁返回的數據中出現(xiàn)了亂碼,這就需要我們轉碼了�。

加一行代碼自動轉碼。

response.encoding = response.apparent_encoding

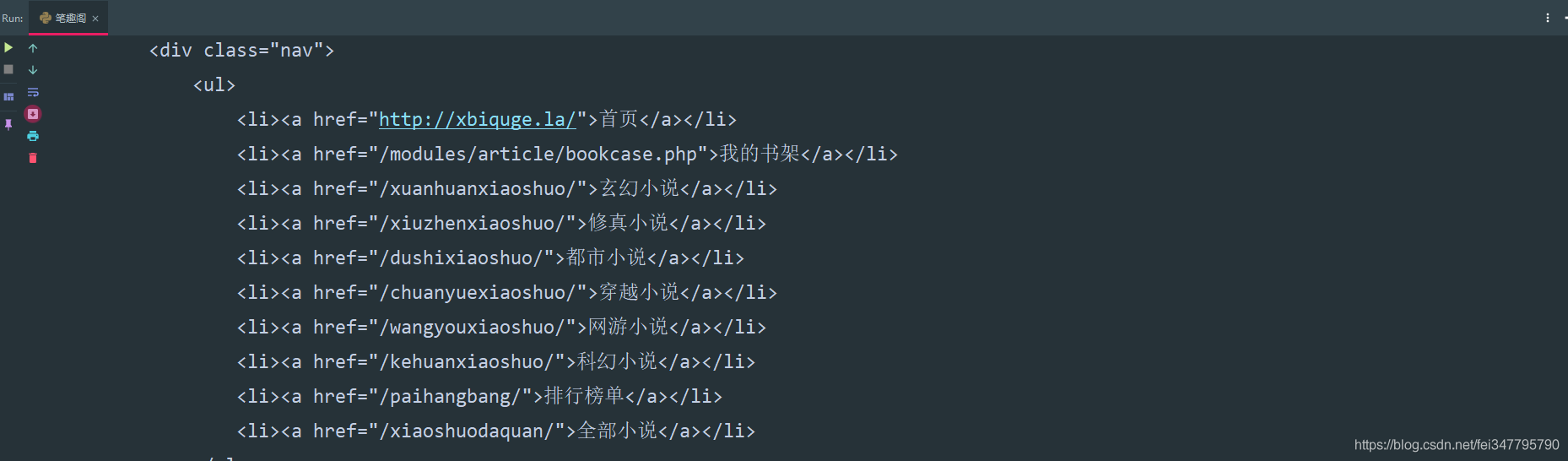

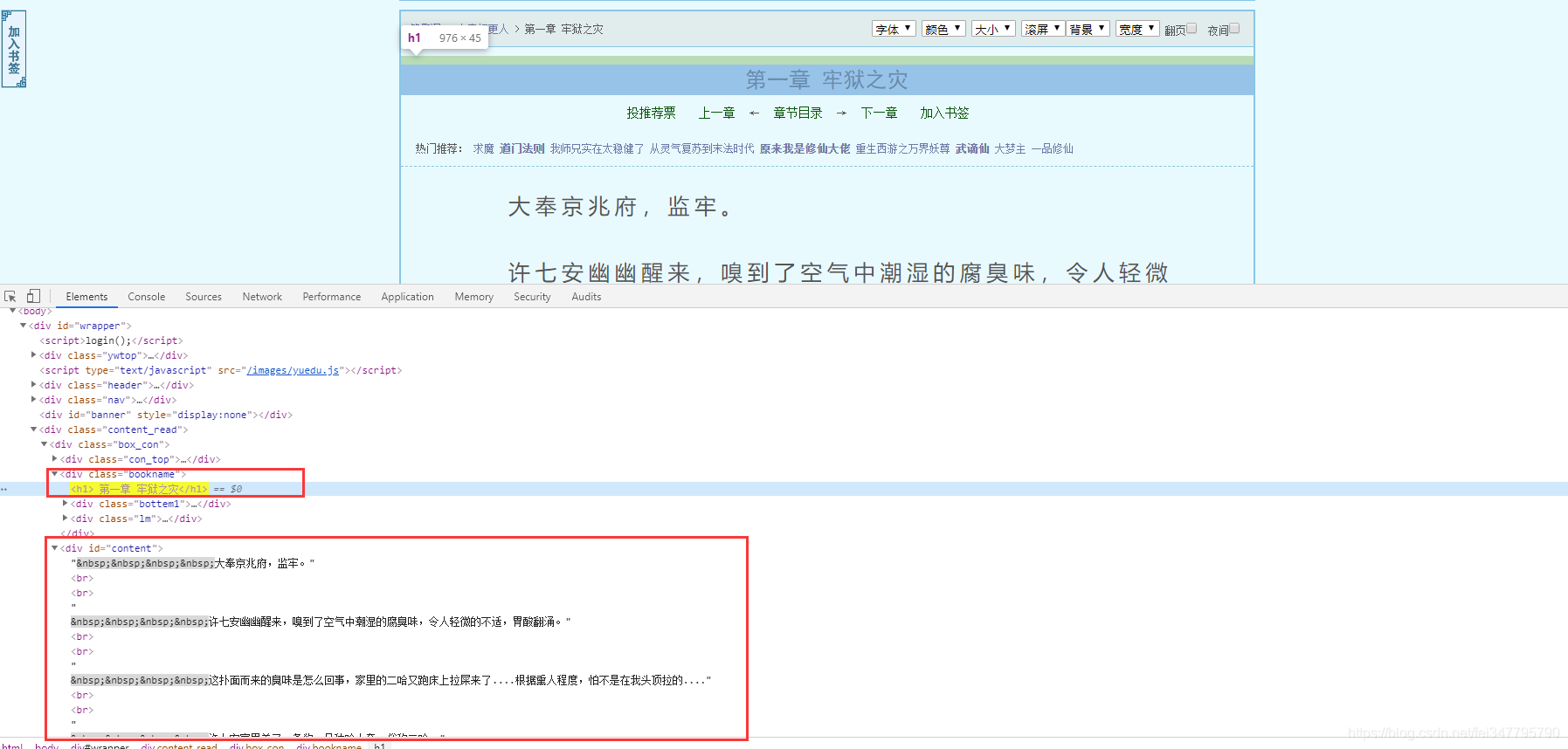

三�、解析數據

根據css選擇器可以直接提取小說標題以及小說內容。

def get_one_novel(html_url):

# 調用請求網頁數據函數

response = get_response(html_url)

# 轉行成selector解析對象

selector = parsel.Selector(response.text)

# 獲取小說標題

title = selector.css('.bookname h1::text').get()

# 獲取小說內容 返回的是list

content_list = selector.css('#content::text').getall()

# ''.join(列表) 把列表轉換成字符串

content_str = ''.join(content_list)

print(title, content_str)

if __name__ == '__main__':

url = 'http://www.biquges.com/52_52642/25585323.html'

get_one_novel(url)

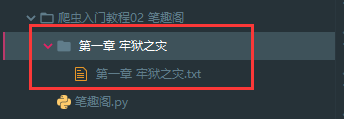

四�、保存數據(數據持久化)

使用常用的保存方式: with open

def save(title, content):

"""

保存小說

:param title: 小說章節(jié)標題

:param content: 小說內容

:return:

"""

# 路徑

filename = f'{title}\\'

# os 內置模塊,自動創(chuàng)建文件夾

if os.makedirs(filename):

os.mkdir()

# 一定要記得加后綴 .txt mode 保存方式 a 是追加保存 encoding 保存編碼

with open(filename + title + '.txt', mode='a', encoding='utf-8') as f:

# 寫入標題

f.write(title)

# 換行

f.write('\n')

# 寫入小說內容

f.write(content)

保存一章小說��,就這樣寫完了���,如果想要保存整本小說呢���?

整本小說爬蟲

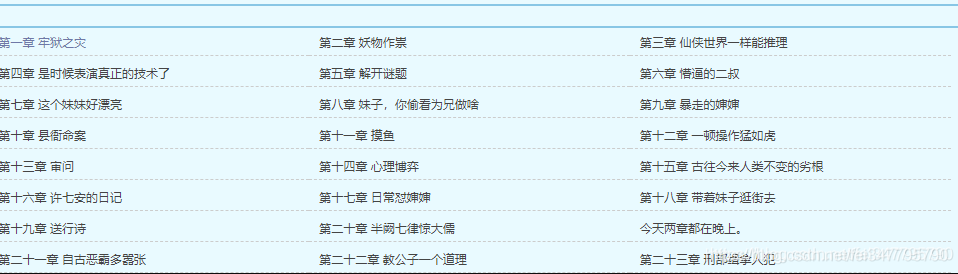

既然爬取單章小說知道怎么爬取了,那么只需要獲取小說所有單章小說的url地址����,就可以爬取全部小說內容了。

所有的單章的url地址都在 dd 標簽當中���,但是這個url地址是不完整的���,所以爬取下來的時候,要拼接url地址����。

def get_all_url(html_url):

# 調用請求網頁數據函數

response = get_response(html_url)

# 轉行成selector解析對象

selector = parsel.Selector(response.text)

# 所有的url地址都在 a 標簽里面的 href 屬性中

dds = selector.css('#list dd a::attr(href)').getall()

for dd in dds:

novel_url = 'http://www.biquges.com' + dd

print(novel_url)

if __name__ == '__main__':

url = 'http://www.biquges.com/52_52642/index.html'

get_all_url(url)

這樣就獲取了所有的小說章節(jié)url地址了。

爬取全本完整代碼

import requests

import parsel

from tqdm import tqdm

def get_response(html_url):

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/81.0.4044.138 Safari/537.36'

}

response = requests.get(url=html_url, headers=headers)

response.encoding = response.apparent_encoding

return response

def save(novel_name, title, content):

"""

保存小說

:param title: 小說章節(jié)標題

:param content: 小說內容

:return:

"""

filename = f'{novel_name}' + '.txt'

# 一定要記得加后綴 .txt mode 保存方式 a 是追加保存 encoding 保存編碼

with open(filename, mode='a', encoding='utf-8') as f:

# 寫入標題

f.write(title)

# 換行

f.write('\n')

# 寫入小說內容

f.write(content)

def get_one_novel(name, novel_url):

# 調用請求網頁數據函數

response = get_response(novel_url)

# 轉行成selector解析對象

selector = parsel.Selector(response.text)

# 獲取小說標題

title = selector.css('.bookname h1::text').get()

# 獲取小說內容 返回的是list

content_list = selector.css('#content::text').getall()

# ''.join(列表) 把列表轉換成字符串

content_str = ''.join(content_list)

save(name, title, content_str)

def get_all_url(html_url):

# 調用請求網頁數據函數

response = get_response(html_url)

# 轉行成selector解析對象

selector = parsel.Selector(response.text)

# 所有的url地址都在 a 標簽里面的 href 屬性中

dds = selector.css('#list dd a::attr(href)').getall()

# 小說名字

novel_name = selector.css('#info h1::text').get()

for dd in tqdm(dds):

novel_url = 'http://www.biquges.com' + dd

get_one_novel(novel_name, novel_url)

if __name__ == '__main__':

novel_id = input('輸入書名ID:')

url = f'http://www.biquges.com/{novel_id}/index.html'

get_all_url(url)

到此這篇關于Python爬蟲入門教程02之筆趣閣小說爬取的文章就介紹到這了,更多相關Python爬蟲筆趣閣小說爬取內容請搜索腳本之家以前的文章或繼續(xù)瀏覽下面的相關文章希望大家以后多多支持腳本之家���!

您可能感興趣的文章:- python 爬取國內小說網站

- python 爬取小說并下載的示例

- python爬取”頂點小說網“《純陽劍尊》的示例代碼

- Python爬取365好書中小說代碼實例

- Python實現(xiàn)的爬取小說爬蟲功能示例

- Python scrapy爬取起點中文網小說榜單

- python爬蟲之爬取筆趣閣小說升級版